谷歌爬虫抓取,谷歌爬虫的抓取行为

在当今数字化的时代,搜索引擎的作用愈发重要,而谷歌作为全球领先的搜索引擎,其爬虫抓取技术更是备受关注,谷歌爬虫抓取究竟是什么呢?

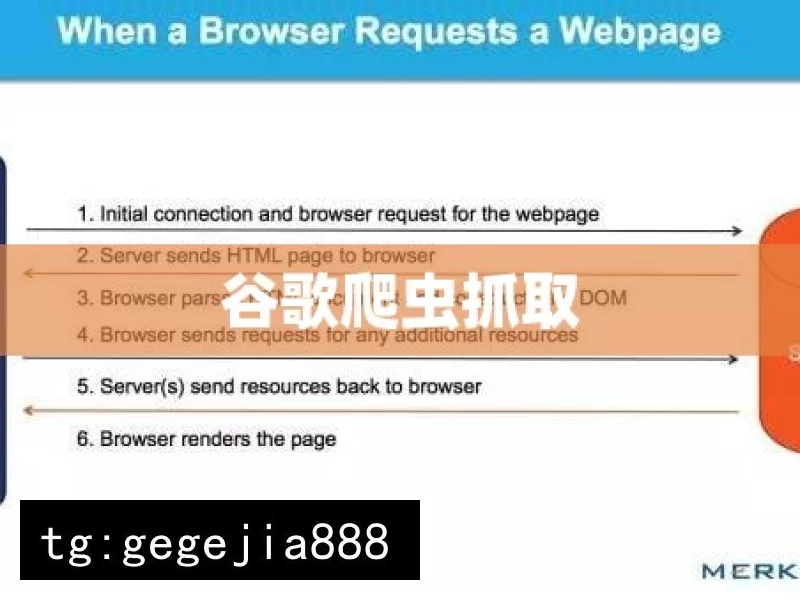

谷歌爬虫,也被称为谷歌蜘蛛,是谷歌搜索引擎用于发现和索引网页的自动化程序,它会按照一定的规则和算法,遍历互联网上的大量网页,收集信息并将其纳入谷歌的数据库中,通过这种方式,当用户在谷歌上进行搜索时,搜索引擎能够快速准确地提供相关的搜索结果。

谷歌爬虫抓取的过程并非简单的随机访问网页,它会根据一系列的因素来决定哪些网页需要优先抓取,以及抓取的频率,这些因素包括网页的质量、更新频率、链接结构等,高质量、丰富且经常更新的网页往往会被谷歌爬虫更频繁地访问,从而在搜索结果中获得更好的排名。

对于网站所有者来说,了解谷歌爬虫抓取的原理和规则是非常重要的,通过优化网站的结构、和链接,使其更符合谷歌爬虫的喜好,可以提高网站在搜索引擎中的可见性,吸引更多的流量,确保网站具有清晰的导航结构、快速的加载速度、高质量的原创以及合理的关键词布局等,都有助于提高网站被谷歌爬虫抓取和索引的效果。

谷歌爬虫抓取也面临着一些挑战和问题,一些网站可能会采用不正当的手段来欺骗爬虫,提高自己的排名,这就需要谷歌不断改进和完善其算法,以确保搜索结果的公正性和准确性,随着互联网的不断发展,新的技术和形式不断涌现,谷歌爬虫也需要不断地适应和进化,以更好地满足用户的需求。

谷歌爬虫抓取是谷歌搜索引擎的重要组成部分,它对于互联网的信息传播和用户获取信息都有着至关重要的作用,我们应该深入了解其工作原理和规则,以便更好地利用搜索引擎,同时也为互联网的健康发展做出贡献。

看法与观点:谷歌爬虫抓取是一个复杂而又关键的技术,它对于搜索引擎的性能和用户体验有着深远的影响,在信息爆炸的时代,谷歌爬虫的有效抓取和索引能够帮助用户更快速地找到所需的信息,这对于提高互联网的效率和价值具有重要意义,网站所有者也应该积极适应谷歌爬虫的规则,通过合法的优化手段提高网站的可见性,实现自身的发展,我们也应该意识到,谷歌爬虫抓取技术需要不断地改进和完善,以应对各种挑战和问题,确保搜索引擎的公正性和准确性,只有这样,才能使谷歌爬虫抓取技术更好地服务于用户和互联网的发展。